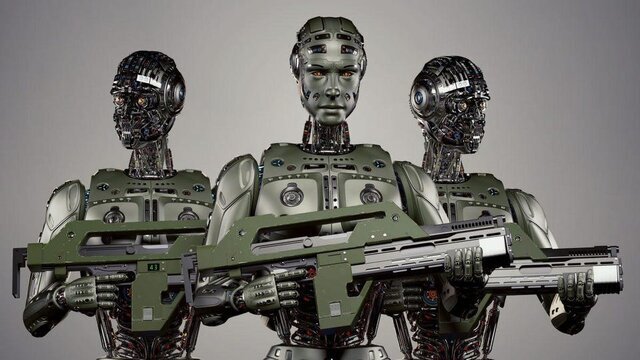

شاید در آینده رباتهای قاتلی که امروزه در فیلمها میبینیم بتوانند با یک پیشرفت سریع در هوش مصنوعی تبدیل به یک واقعیت شوند. محققان معتقدند که با توجه به سرمایهگذاری هنگفت دولتی و بخش خصوصی در زمینه تولید رباتهای هوشمند جنگی، باید وجه منفی عملکرد این تجهیزات کشنده را نیز در نظر گرفت.

ممکن است در مورد رباتهای قاتل، رباتهای سلاخی یا رباتهای نابود کننده(که رسماً به آنها سلاحهای خودکار کشنده(LAWs) گفته میشود) در فیلمها و کتابها شنیده باشید اما ایده تسلیحات فوقهوشمند که بسیار خطرناک هستند هنوز علمی تخیلی است. اما همانطور که سلاحهای هوش مصنوعی به طور فزایندهای پیچیده میشوند، نگرانی عمومی در مورد ترس از عدم پاسخگویی و خطر نقص فنی افزایش مییابد.

قبلا دیدهایم که هوش مصنوعی خنثی چگونه الگوریتمهای جنسیتی و سیستمهای تعدیل محتوای نامناسب را ایجاد کرده است، عمدتاً به این دلیل که سازندگان آنها این فناوری را درک نکردهاند. اما در جنگ، این نوع سوء تفاهمها میتواند غیرنظامیان را بکشد یا مذاکرات را خراب کند.

دانشمندان معتقدند که با روی کار آمدن فناوری رباتیک به عنوان ابزاری جهت کشتن انسانها چه به صورت خودکار و یا کنترل از راه دور، تصمیمگیری برای کشتن شهروندان بیگناه بسیار آسانتر از شرایط واقعی خواهد شد.

به عنوان مثال، به یک الگوریتم تشخیص هدف میتوان نحوه شناسایی مخازن از تصاویر ماهوارهای را آموزش داد. اما اگر تمام تصاویری که برای آموزش سیستم استفاده میشوند، سربازانی را در اطراف تانک نشان میدادند، چه؟ حتی ممکن است این الگوریتم یک وسیله نقلیه غیرنظامی که از منطقه نظامی عبور میکند را با هدف خاصش اشتباه بگیرد.

کارشناسان رباتیک همچنین پیشتر گفته بودند که جایگزینی هوش مصنوعی در هدفگیری و تصمیم به شلیک به جای منطق انسان یک تصمیم کاملا خطرناک و غیرعاقلانه است، چرا که در این حالت یک ربات تصمیم میگیرد که به یک هدف انسانی بدون در نظر گرفتن منطق و اهمیت جان انسان شلیک کند.

چرا ما به سلاحهای خودکار نیاز داریم؟

غیرنظامیان در بسیاری از کشورها(مانند ویتنام، افغانستان و یمن) به دلیل شیوهای که ابرقدرتهای جهانی در ساخت و استفاده از سلاحهای پیشرفته به طور فزایندهای استفاده میکنند، آسیب دیدهاند. بسیاری از مردم استدلال میکنند که بیشتر ضرر کردهاند تا سود که نمونه اخیراً آن حمله روسیه به اوکراین در اوایل سال ۲۰۲۲ است.

در طرفی دیگر، افرادی هستند که میگویند یک کشور باید بتواند از خود دفاع کند که این امر به معنای همگام شدن با فناوری نظامی کشورهای دیگر است. هوش مصنوعی میتواند در شطرنج و پوکر از انسان پیشی بگیرد. در دنیای واقعی نیز از انسانها بهتر عمل میکند. به عنوان مثال مایکروسافت ادعا میکند که نرم افزار تشخیص گفتار آن دارای نرخ خطای یک درصد است و این در حالی است که نرخ خطای انسانی حدود شش درصد است. بنابراین تعجب آور نیست که ارتشها به آرامی کنترل الگوریتمها را به دست بگیرند. اما چگونه از افزودن رباتهای قاتل به فهرست طولانی چیزهایی که آرزو میکردیم هرگز اختراع نکرده بودیم اجتناب کنیم؟ اول از همه: دشمنت را بشناس.

سلاحهای خودکار کشنده(LAW) چه هستند؟

وزارت دفاع ایالات متحده سیستم تسلیحاتی خودکار را اینگونه تعریف میکند: سیستم تسلیحاتی که پس از فعال شدن، میتواند اهداف را بدون دخالت بیشتر اپراتور انسانی انتخاب کرده و مورد هدف قرار دهد. بسیاری از سیستمهای رزمی در حال حاضر با این معیار مطابقت دارند. رایانههای روی پهپادها و موشکهای مدرن الگوریتمهایی دارند که میتوانند اهداف را شناسایی کرده و با دقت بسیار بیشتری نسبت به اپراتور انسانی به سمت آنها شلیک کنند. سلاحهای مجهز به هوش مصنوعی نیز وجود دارند که برای حمله به مردم طراحی شدهاند، از ربات نگهبان گرفته تا پهپادهای کامیکازه سرگردان که در جنگ اوکراین استفاده میشوند. پهپاد انتحاری، پهپاد کامیکازه یا مهمات پرسهزن (Loitering munition) نوعی سامانه تسلیحاتی است که در آن مهمات برای مدتی در محدودهای هدف را جستجو میکنند(اصطلاحا «پرسهزنی» میکنند) و پس از یافتن هدف به آن حمله میکنند.

قوانین جنگ

توافقنامههای بینالمللی مانند کنوانسیونهای ژنو، رفتاری را برای رفتار با اسیران جنگی و غیرنظامیان در هنگام درگیری ایجاد میکنند. آنها یکی از معدود ابزارهایی هستند که ما برای کنترل نحوه جنگیدن داریم. متأسفانه، استفاده از سلاحهای شیمیایی توسط ایالات متحده در ویتنام و توسط روسیه در افغانستان، دلیلی بر عدم موفقیت این اقدامات است. کارزار جهانی علیه مینهای زمینی(ICBL) برای ممنوعیت استفاده از مینهای زمینی از سال ۱۹۹۲ در حال تعامل و همکلاری با سیاستمداران برای ممنوعیت استفاده از مینها و مهمات خوشهای(که به طور تصادفی بمبهای کوچک را در منطقه وسیعی پراکنده میکند) بوده است. در سال ۱۹۹۷ معاهده اتاوا شامل ممنوعیت استفاده از این سلاحها بود که ۱۲۲ کشور آن را امضا کردند. اما آمریکا، چین و روسیه در این کار شرکت نکردند.

مینهای زمینی از سال ۲۰۱۵ سالانه حداقل ۵۰۰۰ سرباز و غیرنظامی را مجروح کرده و آنها جان خود را از دست دادهاند و در سال ۲۰۱۷ حدود ۹۴۴۰ نفر کشته شدهاند. با وجود تلاشهای زیاد کارزار جهانی علیه مینهای زمینی، شواهدی وجود دارد که هم روسیه و هم اوکراین(عضو معاهده اتاوا) از مینهای زمینی در طول تهاجم روسیه به اوکراین استفاده میکنند.

آینده ما

تقریباً مطمئناً در آینده شاهد سلاحهای بیشتری مبتنی بر هوش مصنوعی خواهیم بود. ممنوعیتهای دقیقتر و ظریفتر به سالم نگه داشتن سیاره و افراد کمک میکند. ماشینهای هوشمند با قابلیت حمله به اهداف تعیین شده بدون نیاز به دخالت انسانی، اصلیترین دغدغه گروههای ضد توسعه «رباتهای قاتل» محسوب میشود. چندی پیش یک مهندس اسبق "گوگل" راجع به نسل جدید رباتها که میتوانند در آینده کشنده باشند، ابراز ترس کرد. "لارا نولان" که پیش از این در پروژه پهپادهای نظامی گوگل کار میکرد، خواستار ممنوعیت استفاده از پهپادهای جنگی خودکار شد، زیرا این دستگاهها احساسات انسانی ندارند.

این پروژه تحت عنوان برنامه هوش مصنوعی پنتاگون به نام پروژه "ماون"(Maven) انجام میشود، روی تفکیک دشمن از مردم و دیگر اشیاء تمرکز داشت ولی پس از اعتراض کارمندان به این فناوری لغو گردید.

به گزارش روزنامه گاردین، در سال ۲۰۱۸ میلادی نولان با هدف اعتراض به فناوری پهپادهای ارتش، از گوگل کنارهگیری کرد. وی اکنون خواستار این موضوع شده که تمام پهپادهای بدون سرنشین که توسط انسان اداره نمیشوند، مانند سلاحهای شیمیایی ممنوع شوند.

نولان اظهار کرد، این رباتهای کشنده باید متوقف شوند زیرا میتوانند منجر به بروز قتلهای غیرقانونی شوند. وی افزود، ممکن است با استفاده از این رباتها حوادث بزرگ و وحشتناکی رخ دهد زیرا آنها رفتارهای غیر منتظرهای از خود نشان میدهند. به همین دلیل هر سیستم تسلیحاتی پیشرفته باید تحت کنترل دقیق انسان قرار گیرد. در غیر این صورت باید از استفاده از آن پیشگیری شود زیرا بسیار خطرناک خواهد بود.

حضور رباتهای قاتل در پلیس آمریکا

با منتشر شدن خبرهایی مبنی بر استفاده از رباتها در ماموریتهای پلیس آمریکا و مسلح کردن آنها، واکنشهای منفی نسبت به این موضوع شدت گرفتهاند. اخیرا مسئولان شهر سانفرانسیسکو به پلیس این شهر این اختیار را دادند که از رباتهای قابل کنترل از راه دور استفاده کند. این رباتها، ماشینهایی به اندازه سگ هستند که از چرخدندهها و اهرمهای تعبیهشده روی چرخها ساخته شدهاند و در حال حاضر میتوان آنها را برای کشتن آموزش داد.

این مجوز، به افسران پلیس اجازه میدهد تا بمبی را به بازوی مکانیکی ربات ببندند، آن را در مجاورت قانونشکن مورد نظر قرار دهند و دکمهای را بزنند تا منفجر شود. این راهبرد شش سال پیش در دالاس آغاز شد؛ زمانی که پلیس چند ساعت با یک تکتیرانداز در کشمکش گرفتار شد که پنج مامور را کشته بود. زمانی که آنها یک ربات حامل مواد منفجره را مستقر کردند، کشمکش پایان یافت. این اقدام در آن زمان، کارشناسان را در مورد استفاده از نیروی مرگبار ربات شگفتزده کرد.

آن اقدام، بحثهای داغی را برانگیخت مبنی بر اینکه آیا پلیس باید مجوز کشتن با چنین سیستمهای پیشرفتهای را برای پایان دادن به زندگی انسانها داشته باشد یا خیر. ناوگان رباتهای سانفرانسیسکو در حال حاضر برای شناسایی، مأموریتهای نجات و عملیات خنثیسازی بمب استفاده میشوند. براساس مجوز شهر سانفرانسیسکو، زمانی که خطر جان باختن عموم مردم یا ماموران قریبالوقوع است و پلیس نمیتواند تهدید را با استفاده از نیروی جایگزین یا تاکتیکهای کاهش تنش مهار کند، میتواند به رباتهای کشتار زمینی فرمان دهد.

داستانهای علمی-تخیلی به واقعیت علمی تبدیل میشوند

برای آمریکاییها که فیلمهای هالیوودی بسیاری را درباره آخرالزمان هوش مصنوعی دیدهاند، این حقیقتی تاریک است. پس از اینکه یکی از رباتهای چهارپای شرکت "گوست روباتیکس"(Ghost Robotics) که محصولاتی را برای ارتش آمریکا عرضه میکند، در حال به کار بردن سلاح طی کنفرانسی در واشنگتندیسی به نمایش گذاشته شد، این شرکت در اکتبر گذشته به تیتر خبرها تبدیل شد و واکنشهایی را دریافت کرد.

مجریان قانون در سانفرانسیسکو طی سالهای اخیر، انبار مهمات رو به رشدی را توسعه دادهاند. طبق گزارشها، یکی از برنامههای فدرال آن با نارنجکانداز، سرنیزه، خودروهای زرهی و لباسهای استتار آمیخته است. این شهر گفت که ناوگان آن متشکل از ۱۲ ربات است که بخشی از آنها با دلارهای فدرال خریداری شدهاند و حاصل مازاد نظامی نیستند. یکی از مدلهای آن موسوم به "QinetiQ TALON"، یک ربات جنگی مشهور است. "اداره پلیس سانفرانسیسکو"(SFPD) در ماه سپتامبر سال گذشته، حق نظارت بر خروجیهای ویدئویی زنده را که از دوربینهای خصوصی متعلق به مشاغل و غیرنظامیان به دست میآیند، دریافت کرد که به ایجاد ترس از یک دولت نظارتی رو به رشد منجر شد. برخی از کاربران توییتر این واقعیت را هدف گرفتند که پلیس و رسانهها به طور یکسان سعی دارند تا این موضوع را ثابت کنند که رباتهای پلیس حامل مسلسل یا موشک هستهای نیستند، بلکه فقط مواد منفجره متوسط را حمل میکنند.

پشتیبانی تلگرام و واتس اپ : 09012990801

پشتیبانی تلگرام و واتس اپ : 09012990801

دیدگاه خود را بنویسید